Bildiğiniz gibi Apple geçtiğimiz hafta macOS 26.2 güncellemesini yayınladı. Bu güncellemede gelen yenilikler arasında Thunderbolt 5 portu üzerinden RDMA networking desteği de bulunuyordu. Peki nedir bu RDMA networking?

RDMA, Remote Direct Access Memory (uzaktan doğrudan bellek erişimi) kelimelerinin kısaltması olan bir teknolojidir. RDMA ağı kurarak birbirlerine bağlanmış bilgisayarların belleklerini ortak kullanabilmek mümkündür.

Birden fazla Mac’i cluster modunda birbirlerine bağlayarak Apple Silicon’un paylaşımlı belleklerini ortak olarak kullanabilirsiniz. Mesela ülkemizde satılan en güçlü Mac olan Mac Studio M3 Ultra’dan 4 tanesini birbirlerine bağlayarak 2TB (yazıyla iki terabayt) birleşik bellek elde edebilirsiniz.

Bunu yapabilmek için ödemeniz gereken tutarları ve satmamız gereken böbrekleri konuşarak moralimizi bozmayalım, biz teknik konulara odaklanarak ilerleyelim.

Bu, Apple’ın cluster yapıları ile ilk münasebeti de değil. xServe ve MacOS X Server zamanlarında sunulan xGrid isimli bir sunucu servisi, bize birdan fazla cihazı aynı anda aynı işe koşturabilme olanağını veriyordu. Bu yapı o dönemdeki MacOS cihazlarda birer client olarak bulunuyordu ve bir MacOS X Server üzerinden cihazlardaki bu client’lar aktive edilebiliyordu. Apple’ın sunucu tabanlı ürünlerini sonlandırmaya başladığı 2010’lu yılların başlarında xGrid de bundan nasibini aldı.

Apple’ın tarihi boyunca piyasaya sürdüğü sunucu sistemleri hakkında bilgi edinmek isterseniz bu yazı da ilginizi çekebilir.

Buna neden ihtiyacımız olsun?

Yapay zeka kullanımı hayatımızın her alanına girdi malumunuz. Siz bilgisayarınızda ChatGPT veya Copilot‘u açıp “Buzlukta tavuk but var. Bana bununla yapılacak 3 tane tarif verir misin?” yazdığınızda bu sorgu doğrudan OpenAI veya Microsoft‘un veri merkezlerine gönderilir ve orada cevaplanır. Sizin yapay zeka araçlarında yaptığınız sorgular için kullandığınız MacBook Pro veya iPhone, aslında birer dummy terminal görevindedir. Yaptığınız sorgular, bilgisayarınızın sistem kaynaklarını kullanmaz.

Ama bununla beraber, eğer isterseniz OpenAI veya DeepSeek‘in yayınladığı LLM‘leri kendi bilgisayarınıza indirerek LM Studio benzeri bir uygulama üzerinden lokalde de çalıştırabilirsiniz. Bunu neden yapmak isteyesiniz? Birkaç farklı nedeni var. Öncelikle, güvenlik. Bir yapay zeka aracına şirketiniz ile ilgili bir sözleşmeyi yükleyip analiz etmesini isterseniz en basitinden o sözleşmenin şartlarını dünyanın geri kalanı ile paylaşmış olursunuz. Ya da özenle yazdığınız bir kodun hatalarını ayıklamak için AI’dan destek istediğiniz an, size özel olan o kod, dünyanın ortak mirasına katılmış oluyor.

Bir LLM‘i lokalinizde çalıştırmak için sizi motive edebilecek bir diğer unsur da maliyet olabilir. Multimodal bir AI aracını kullanmaya o kadar da ihtiyaç duymuyorsanız örneğin ChatGPT‘nin aylık $20‘lık aboneliğine de para vermeniz gerekmez.

Bir LLM’i lokalinizde çalıştırmak istediğinizde artık bilgisayarınız bir dummy terminal değildir ve kendi işlem gücü kullanılmaya başlanır. Tabi önünüzde duran emektar MacBook Air’iniz, OpenAI’ın trilyor dolarlık veri merkezleri ile işlem gücü olarak yarışamayacağı için fazla karmaşık taleplerde bulunduğunuzda biraz daha yavaş cevaplar alabilirsiniz.

Yapay zeka araçlarının hızları sözkonusu olduğunda dikkate alınacak ölçü birimi Token/Saniye’dir. Yazdığınız her sorgu ve aldığınız her cevap bu ölçü birimine göre değerlendirilir. ChatGPT’yi ücretsiz olarak kullanıyorsanız, bir miktar kullanım sonrasında “Abonelik paketlerimiz de var, istemez miydiniz” demesi bu yüzden. Ücretsiz hesaplarda günlük belirli bir Token sınırı bulunur ve bunun üzerinde işlem yaptırmaz.

İsterseniz biz tekrar LLM’i lokalde çalıştırma konusuna dönelim. LLM’leri lokalde çalıştırma gereksinimi ile birlikte bilgisayarları cluster modunda kullanmak da yeniden popüler oldu. Burada bir yanlış anlaşılma olmasın. Sunucu cluster yapılarından bahsetmiyorum. O zaten her daim kullanılıyor durumda. Ama küçük çalışma gruplarının kişisel bilgisayarlarını veya workstation bilgisayarlarının gücünü birleştirmesi ve mini birer süper bilgisayar modunda kullanmalarını kastediyorum. Bilgisayarları kullanarak bir cluster oluşturmanın temel motivasyonu da daha yüksek işlem hızı elde etmek. Kullandığınız bir M4 işlemcili MacBook Pro, tek başına bir sorgu için saniyede örneğin 5 Token hızında veri işleyebiliyor iken, birkaç bilgisayarın biraraya gelmesi ile oluşturulmuş bir cluster örneğin 25 Token işleyebilir. Bu da sorgularınıza daha hızlı yanıtlar alabileceğini anlamına geliyor.

Bunun için neye ihtiyacımız var?

Mac

RDMA over Thunderbolt, kullanacağınız bilgisayarlarda birer Thunderbolt 5 kapısı bulunmasını gerektiriyor. Dolayısıyla ilk ihtiyacınız, bir cluster oluşturabilecek Thunderbolt 5 desteği bulunan birkaç tane Mac. Bu yazının yazıldığı Aralık 2025 tarihinde Apple’ın ürün gamı içinden sadece aşağıdaki bilgisayarlar Thunderbolt 5 kapısına sahip durumdalar.

• M4 Pro ve M4 Max işlemcili MacBook Pro’lar

• M4 Pro işlemcili Mac mini (dikkat, en uygun fiyatlı Mac mini değil)

• M4 Max işlemcili Mac Studio

• M3 Ultra işlemcili Mac Studio

RDMA desteği yukarıdaki satırlarda da yazdığımız gibi macOS 26.2 güncellemesi ile birlikte geldi. Yani kullanacağınız Mac’lerin tümünde bu versiyon çalışıyor olmalı.

Mac başlığını kapatmadan küçük bir not daha ekleyeyim. Hayır, M5 işlemcili MacBook Pro’yu listeye yazmayı unutmadım. M5 MacBook Pro’nun piyasaya çıkan ilk modelinde Thunderbolt 5 kapısı bulunmuyor.

Thunderbolt Kablo

Doğal olarak Thunderbolt 5 kablolara ihtiyacınız var. Kendisini bu adresten inceleyebilirsiniz. Amacınız 4 tane Mac Studio’yu birbirlerine bağlamak ise toplam 6 adet Thunderbolt 5 kabloya ihtiyacınız olur.

Exo

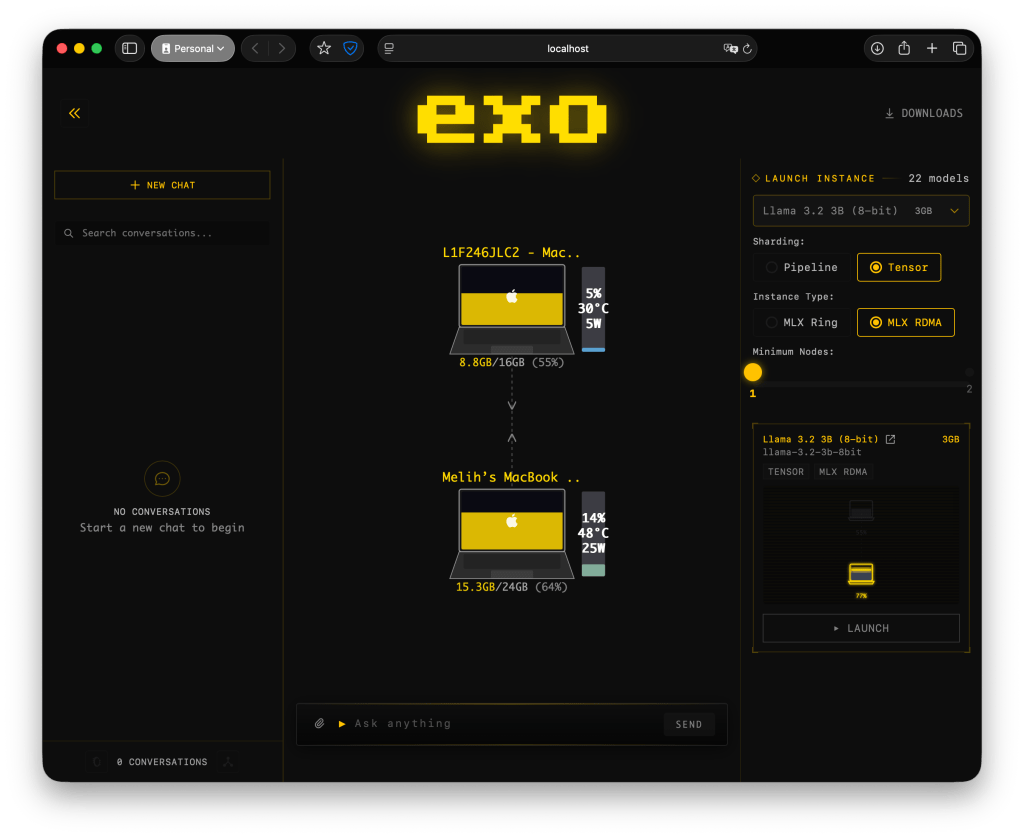

Mac’lerin bir cluster yapısında çalışmasını sağlayabilmek için bir çözüme ihtiyacınız olacak. Bunu Exo isimli açık kaynak bir proje gayet güzel bir şekilde yapıyor. Exo’yu bu adresten inceleyebilir ve indirebilirsiniz. Exo‘yu cluster yapısı içinde kullanacağınız tüm Mac’lere yüklemeniz ve uygulama içinden kullanacağınız LLM‘i seçip indirmeniz gerekiyor. Bazı modeller biraz fazlaca büyük. Örneğin DeepSeek‘i indirmek isterseniz bilgisayarınızda 700GB boş yer bulunuyor olması gerekiyor. Eğer böyle bir boş alan yoksa Exo içinden o modelleri de indirilebilir olarak göremiyorsunuz.

Exo’yu günübirlik herhangi bir işte kullanmak için mutlaka RDMA yapısına veya Thunderbolt kablolara ihtiyacınız yok. Sadece ağınızda bulunan Mac’lere Exo‘yu yükleyin ve aktif hale getirin. Sonrasında Exo içinden yapacağınız sorgular, sadece kendi bilgisayarınızın kaynakları değil, tüm cluster yapısının kaynakları kullanılarak cevaplandırılır. Yukarıdaki ekran görüntüsünde benim kullandığım iki Mac aynı görevi paylaşırken görünüyor.

RDMA’ı nasıl aktif hale getiririm?

Mac’inizi macOS Recovery‘den başlatmalı ve Utilities menüsünden Terminal’i açıp şunu yazmalısınız.

rdma_ctl enableBunu yukarıdaki bilgisayar listesi dışında bir cihazda yazdığınızda hata verecektir. Ama Thunderbolt 5 kapısı bulunan bir cihazda uyguladığınızda RDMA enabled gibi bir onay mesajı görürsünüz.

Parçaları birleştirelim

• Thunderbolt 5 destekli Mac’lerinizi aldınız.

• Thunderbolt 5 kabloları ile onları birbirine bağladınız.

• Hepsinin işletim sistemini 26.2’ye güncellediniz.

• Hepsinde macOS Recovery üzerinden RDMA’i aktif hale getirdiniz.

• Tüm bilgisayarlara Exo’yu yüklediniz.

• Exo içinden kullanmak istediğiniz modeli seçtiniz ve indirdiniz.

Bu noktada artık kullanacağınız modeli çalıştırmamak için bir eksiğiniz bulunmuyor. Exo içinden istediğiniz soruyu sorarak işe koyulabilirsiniz. Ama…

Bu noktada küçük bir ek daha yapacağım. Biz bütün parayı ve zamanımızı daha yüksek hız elde edebilmek için harcadık. Ama bilgisayarlarımızın gücünü son damlasına kadar kullanabilmek için yapbozun bir eksik parçası daha var: MLX

MLX de ne?

MLX, Apple’ın yapay zeka kullanımları için geliştirdiği açık kaynak bir kütüphanedir. MLX‘i kullanan modelleri tercih ettiğinizde kullandığınız model, Apple Silicon’un gücünü daha yoğun bir şekilde kullanmaya başlayacaktır. Bildiğiniz gibi Apple Silicon geçişinden itibaren Mac’lerimiz Unified Memory (Birleşik bellek) kullanmaya başladı. Sistemin belleği CPU, GPU ve Neural Engine tarafından ortaklaşa kullanılır. İşlenecek verinin CPU-Bellek-GPU arasında transfer edilmesi ile oluşabilecek zaman kayıplarının önüne geçilmiş olur. Ki Intel zamanındaki paylaşımlı bellek kullanımı bu şekilde çalışıyordu.

MLX kütüphaneleri, yapay zeka modellerini geliştiren kurumlara Unified Memory‘i tüm gücüyle kullanabilme olanağı tanımış olur. Son kullanıcıların LLM olarak GGUF yerine MLX versiyonu varsa onu tercih etmesi, Apple Silicon’un gücünden %100 yararlanabilme anlamını taşır.

Bilgisayarınızda MLX‘i aktif hale getirmek için önce Python veya xCode yükledikten sonra Terminal’i açıp şunu yazmalısınız.

pip install mlxBuna ek olarak MLX araç setlerini de yüklemek için şu komutu yazmalısınız.

pip install mlx-lmMLX hakkında ek bilgi edinmek için bu adresi veya projenin GitHub sayfasını ziyaret edebilirsiniz.

Ek kaynaklar

Alex Ziskind‘in bu Youtube videosu RDMA networking uygulaması hakkında size çok bilgi verecektir.

Apple’ın WWDC Developer konferansında MLX‘e dair bazı sunumlar da yer aldı. MLX projesinde en aktif olarak çalışan Awni Hannun‘un Get Started with MLX for Apple Silicon sunumunu izleyebilirsiniz.

Yorum bırakın